Rückwärts gedacht

Carmack und die Zukunft

Grenzen? Welche Grenzen?

Kürzlich philosophierte ids John Carmack ein wenig über die Zukunft und sprach von einigen fundamentalen physischen Limits, den sich die Technik nun langsam nähert. Hmm, welche könnten das sein? Ist Leistung nicht endlos steigerbar? Auf ein Gigahertz folgen 10, auf 5 Mbit 500 und auf 95nm Chips (nm = Nanometer: Länge von vier Metallatomen in Folge, ein Haar ist 70000 nm breit oder einfach ein Milliardstel Meter) folgten die 65er, dann die 45er, warum nicht irgendwann die 4,5nm oder 0,45nm Chips? Ganz einfach, die Quantenphysik setzt dem Mikronesentum der Chipbastler dann doch irgendwann Grenzen.

Bisher gilt noch die Grundannahme von Moores Gesetz, dass die Leistungsfähigkeit von Mikroprozessoren – und auch alle anderen Eckdaten technischer Geräte – sich alle zwei Jahre ziemlich genau verdoppelt, also exponentiell wächst. Intels Mitbegründer Gordon E. Moore entdeckte Mitte der 60er diesen Trend, den er damals seit der Erfindung integrierter Schaltkreise 1958 beobachten konnte. Trotz der damals noch kurzen empirischen Beobachtungsspanne hat sich das Gesetz bis heute als ziemlich genau erwiesen und die Roadmaps der Chiphersteller gehen auch ungezügelt von dieser Annahme aus. Zumindest bis zum Ende der nächsten Dekade.

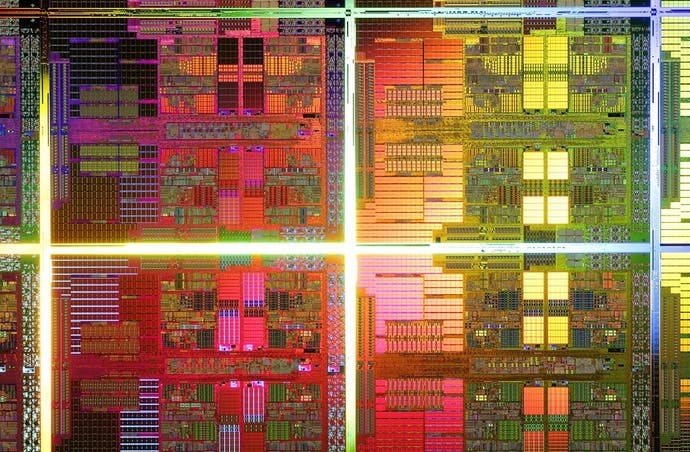

Auch wenn sich das Ganze auf Pixel, Speicherplatz, Stromverbrauch oder Bandbreite anwenden ließe, reicht es fürs Erste bei der Strukturgröße der Fertigung eines Chips zu bleiben. Die Zahl der auf möglichst kleiner Fläche untergebrachter Mikrotransistoren bestimmt schließlich dessen Leistungsfähigkeit. Je mehr 1-0 Schaltungen er in einem Schwung ausführen kann, desto besser. Je kürzer die Wege der Elektronen, desto schneller. Hohe Dichte bedeutet also erst einmal hohe Leistung. Bestimmt wird diese Dichte durch das angewandte Fotolithografieverfahren, dem vielleicht wichtigsten und inzwischen teuersten Schritt bei der Herstellung von Chips, bei dem die Maske des Chips auf Fotolack übertragen wird und anschließend entwickelt wird. Die Strukturinformationen werden dabei auf eine unterliegende Schicht übertragen, anschließend wird der Lack wieder entfernt, zurück bleiben die zu verarbeitenden Wafers.

Die beiden derzeit gängigen Verfahren nutzen die 65 und 45 nm Technik. Erstere finden sich in der letzten Generation von PC-CPUs, der Xbox 360 oder den Cell-Chips der PS3. Intels i7 Serie oder beispielsweise AMDs Phenom 2 nutzen bereits die 45 nm - Technologie. Die nächsten Stufen stehen auch schon fest. Zuerst kommt 33, dann 22, gefolgt von 16 und ab hier beginnt es spannend zu werden. Dazu aber später mehr.

Beware! Here be Technik...

Wenn wir von nm-Technolgien reden, dann stets im Zusammenhang mit dem Begriff CMOS (Complementary Metal Oxide Semiconductor oder deutsch: komplementärer Metall-Oxid-Halbleiter), den heute für diesen Bereich gängigsten Halbleiterbauelementen. Die integrierten CMOS-Schaltungen brauchen nur wenig Strom, haben Verlustleistungen im nWatt-Bereich und sind auch sonst dank relativer Unempfindlichkeit gegenüber normalen Temperaturbedingungen perfekt für den Allroundeinsatz geeignet.

Der theoretisch schlichte Aufbau des CMOS-Designs erlaubt es zumindest gedanklich, dieses bis auf die atomare Ebene herunterzudenken. Praktisch ergeben sich dabei schnell einige Schwierigkeiten. Die meist genutzte Fotolithografie bei der Erstellung der Chip Wafer arbeitet sehr genau und 45nm stellen für die Immersionslithografie (das Licht zwischen Linse und Lackschicht wird durch Reinstwasser gebrochen) derzeit kein Problem dar. IBM hat auch bereits ein Verfahren entwickelt – Double Patterning -, das den Wafer zwei Mal belichtet. Der erste Durchgang nimmt die normale Strukturgröße, hier also 45nm, und der zweite reduziert dies dank der Genauigkeit der Wafer-Stepper um die Hälfte auf 22nm. Mit einer Ausgangsdichte von 35nm (derzeit bereits entwickelt) ließen sich dann sogar 16 nm erreichen. Nach der Roadmap der Halbleiterhersteller befänden wir uns damit im Jahr 2018, wo diese Chips in Massenproduktion sein könnten. Bei dieser Größe dürfte ein einzelner der Logiktransistoren selbst gerade mal noch 5nm groß sein.

Und hier beginnt sich scheinbar die Wand für Moores Law aufzubauen und die reale physische Grenze. Ab einer Größe unter 11nm beginnt offiziell der Bereich der Nanotechnik und das verstärkte Auftreten eines Tunneleffekts bei Transistoren. Hierbei geht es in die Quantenphysik, nach der Elektronen keine Punktobjekte sondern permanent in Bewegung und demnach mit kinetischer Energie ausgestattet sind. Die Wellenlänge kann dabei ziemlich groß sein, bis zu 15nm oder 20nm. Trifft ein solches Wellenpaket unter günstigen Umständen auf eine Barriere, z. B. in einem Transistor, dann kann es vorkommen, dass ein Teil des Pakets einfach auf der anderen Seite, mit geringerer Wellenlänge, sich fortsetzt. In einem System, das davon abhängig ist, eindeutige, aber ständig wechselnde Ja-Nein-Zustände zu haben, kann dieses sonst harmlose und mitunter auch sehr praktische – Flash-Speicher nutzen diesen Effekt – Phänomen die stabile Arbeit eines Chips komplett durcheinanderbringt.

Und wie solls jetzt weitergehen?

Es ist also ab der Grenze von 16nm theoretisch kaum noch möglich, das klassische CMOS-Modell des Chip-Baus weiterzuführen, geschweige denn alle zwei Jahre exponentiell wachsen zu lassen. Bleiben jetzt in zehn Jahren also plötzlich alle Weiterentwicklungen von CPU und Speichermodulen – und damit ja im Effekt auch die von PCs und Spielkonsolen – stecken? Natürlich nicht.

Zum einen lässt es sich immer am Material schrauben und, zumindest was die Bleeding Edge angeht, dürfte hier die Zeit von Silikon vorbei sein. III-V Verbundmaterialien, die sich aus Elementen verschiedener Gruppen des Periodensystem zusammensetzen, könnten günstigere Eigenschaften mitbringen. Auch aus Kohlenstoffnanoröhren könnte was werden. Diese Bauteile sind im einfachsten Fall gerade mal 1nm breit, bringen gute Leitfähigkeiten mit – bei kalten Temperaturen haben sie sogar supraleitende Eigenschaften - und lassen sich gezielt verarbeiten. Derzeit noch nicht simpel, aber vor 15 Jahren hatte auch noch keiner 45nm Chips zuhause.

Dies sind allerdings in erster Linie immer noch neue Varianten des bekannten Designs. Spannender ist da schon die Möglichkeit eines Chips auf rein optischer Basis. Für ein binär arbeitendes System ist es ziemlich egal, ob der 1-0 Zustand über ein geladenes Elektron oder einen Lichtimpuls definiert wird. Ein CD-ROM tut nichts anders, ist dabei aber natürlich nur eine sehr primitive Form dessen, was ein vollständig optischer Chip, bestehend aus optischen Transistoren, leisten müsste. Einen solchen Chip gibt es nicht auf auch nur vage kommerziell relevanter Basis. Leute, die daran forschen, hingegen jede Menge.

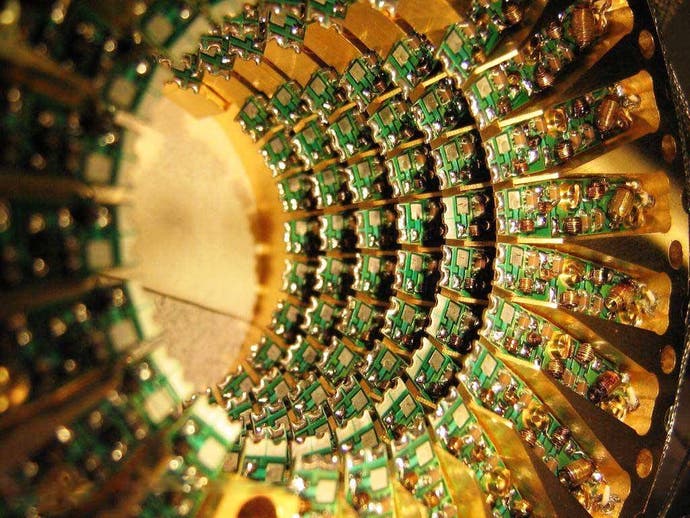

Ebenfalls in den Kinderschuhen stecken Quanten-Computer, die sich eben genau den im klassischen CMOS-Designzstörenden Wellenzustand von Partikeln zunutze machen und statt simplen Bits – 1-0 - Zuständen – plötzlich mit qbits aufwarten: Quanten Bits. Diese kennen nicht nur die Zustände 1 oder 0, sondern auch jeden Zustand, der sich hier aus dem Quantenüberlagerungsprinzip ableiten lässt. Wer sich hier genau einlesen möchte, kann das gerne tun, aber derzeit spielen Quanten-Computer mehr bei gedanklichen Konstruktionen eine Rolle. Für die Kryptografie stellen diese Rechner theoretisch ein echtes Problem dar, da sie in der Lage sind, quantenmathematische Berechnungen durchzuführen, mit denen sich die bisher gängigen und erst nach Jahren aufzulösenden symmetrischen Verschlüsselungen relativ leicht knacken ließen. Ob sie sich auch eignen um Call of Duty 12 mit perfekter Grafik zu versorgen? Wer weiß. Die ersten Quantencomputer werden sich wohl zuerst der Erforschung von Quanten widmen. Klingt paradox? Willkommen in der Quantenphysik.

Während wir wahrscheinlich noch den Aufstieg dieser beiden Technologien erleben werden, dürfte eine dritte Möglichkeit noch ein wenig länger auf sich warten lassen. Dabei gibt es Bio-Computer doch längst. Jeder von uns hat einen mal mehr, mal weniger leistungsfähigen im Kopf. Gehirn gennant. Es gibt Versuche, mittels biologischer Bausteine – Proteine sollen die Binärinformationen speichern – nicht unbedingt das Gehirn nachzubauen, aber einen Computer auf organischer Basis. Die Enthusiasten dieser für den Moment noch im Reich des SciFi angesiedelten Technik versprechen sich große Sachen davon: billig, leistungsfähig und beides ziemlich endlos. Aber wie gesagt, wirklich existieren tut davon noch nicht allzuviel.

John Carmack hat also recht. In ein paar Jahren wird man wahrscheinlich an die physischen Grenzen der herkömmlichen Chiptechnologie - und einiger anderer herkömmlicher Technologien - stoßen und die nächste oder übernächste Konsolengeneration könnte die letzte nach dem uns derzeit bekannten Baumuster sein. Das Ende der Fahnenstange ist damit aber ganz sicher nicht erreicht, selbst wenn Moores Gesetz vielleicht - und das ist ein großes vielleicht, denn es gibt ja Ansätze für die Zukunft – ein oder zwei Jahre Pause machen sollte. Und am Ende kann es uns als Konsumenten eigentlich egal sein, was denn jetzt so genau in der Quanten-Xbox, einer Bio-Wii oder der Photonen-Playstation vor sich hinwerkelt. Aus der Styroporumverpackung werden wir einen Plastikklotz holen, der einen Anschalter, einen Videoausgang und ein Eingabegerät mitbringt. Und mehr brauchte am Ende noch keine Konsole.

Abschließend würde ich gerne noch hinzufügen, dass ich weder Chipdesigner noch Quantenphysiker bin. Wenn ihr zu diesen Berufszweigen gehört und hier euch beim Lesen die Zehennägel aufrollen, dann bedenkt, dass hier nicht alles so ausführlich erklärt sein kann, wie es vielelicht eigentlich sein müsste. Auch wurde natürlich einiges mit Absicht eher verkürzt und stark vereinfacht dargelegt. Habt ihr dies berücksichtigt und seid trotzdem auf ein paar Sachen gestoßen, die ich definitiv einfach in meinem Halblaiendasein falsch verstanden und hier nicht korrekt wiedergegeben habe, dann lasse ich mich gerne belehren. Die Materie ist komplex und ich bin trotz aller Bestrebungen immer noch nicht allwissend.

„Rückwärts gedacht“ erfreut/schockiert/nervt/lockt/reizt/belästigt euch ab sofort wöchentlich mit den großen Gedanken der kleinen Geiste von Alex und Martin.